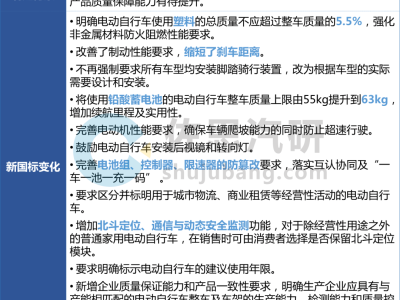

DeepSeek团队在人工智能领域再掀波澜,其最新研究论文《Conditional Memory via Scalable Lookup: A New Axis of Sparsity for Large Language Models》正式发布,提出了一种名为"条件记忆"的创新技术框架。这项突破性成果旨在解决大语言模型在知识检索与动态推理之间的效率矛盾,通过引入稀疏查找机制优化模型架构,为下一代稀疏模型发展开辟新路径。

研究团队由DeepSeek核心成员与北京大学王选所赵东岩、张辉帅团队联合组成,针对现有混合专家模型(MoE)的局限性展开攻关。传统Transformer架构在处理命名实体、公式化表达等静态知识时,需通过多层注意力机制重建检索路径,造成计算资源的浪费。新提出的Engram模块通过稀疏查找操作直接获取静态嵌入,与MoE的动态参数激活形成互补,形成"动态计算+静态检索"的双轨机制。

实验数据显示,在固定参数量和计算量的条件下,将20%-25%的稀疏参数分配给Engram模块可获得最优性能。以100亿参数规模模型为例,验证损失值从1.7248降至1.7109。基于该发现训练的Engram-27B模型,通过调整专家数量与记忆模块配比,在知识推理、代码生成等任务中展现出显著优势:MMLU基准测试提升3.0分,Humaneval代码生成任务提升3.0分,GSM8K数学推理提升2.2分。

这项技术突破的核心在于"U形扩展定律"的发现。研究证实,当Engram内存占比达到总稀疏参数的74.3%时,模型在保持计算效率的同时,能有效释放注意力机制的处理能力。机制分析表明,Engram模块通过将静态知识检索前移至早期网络层,使后续注意力层可专注于全局上下文理解,特别在长文本处理场景中表现出色。

值得关注的是,该研究明确将条件记忆定位为下一代稀疏模型的基础组件。结合近期外媒报道,DeepSeek计划在春节前后发布的新旗舰模型V4,极有可能集成这项创新技术。知情人士透露,内部测试显示V4在代码生成领域已超越Claude、GPT等主流模型,其强劲表现引发行业高度期待。

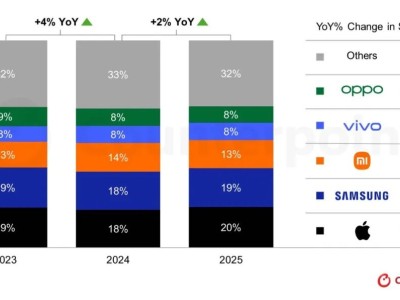

自2024年发布R1模型引发全球关注以来,DeepSeek持续保持技术迭代速度。2025年下半年,该团队平均每月都有重要成果发布:12月开源的V3.2系列模型达到GPT-5水平;11月发布的Math-V2成为首个通过国际奥数金牌测试的开源模型;10月推出的OCR技术通过光学压缩将长文本处理成本降低60%;9月更以百万token输入价格0.2元的策略震动行业。

此次条件记忆技术的突破,标志着大语言模型进入"动态智能+静态知识"的融合发展阶段。通过解耦存储与计算,Engram架构不仅提升了知识检索效率,更重构了模型内部的注意力分配机制。这种设计范式为处理多模态数据、构建通用人工智能提供了新的技术路径,或将重新定义AI模型的能力边界。