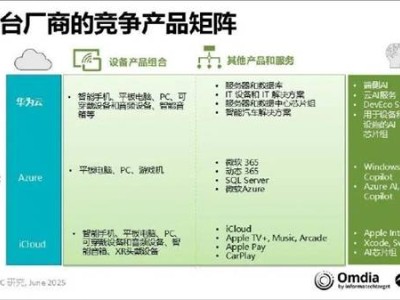

在科技行业的聚光灯下,一场围绕人工智能(AI)算力的竞赛正悄然上演。各大云服务商,包括AWS、微软云、谷歌云,以及中国的腾讯、阿里、华为、百度、字节跳动等,纷纷宣布加大对AI基础设施的投资,智算中心如雨后春笋般涌现,GPU采购量激增,数百亿级资金被注入新一代AI集群的建设中。媒体将其誉为“新基建”,资本市场则视其为“下一个增长引擎”。然而,在这场看似势不可挡的算力扩张背后,一个关键问题逐渐浮出水面:如此庞大的资本支出,其回报真的可期吗?

商业逻辑的本质,从不是愿景的空中楼阁,而是投入产出比的精打细算。在AI应用尚存诸多不确定性的当下,云服务商们提前布局的“超级智算平台”,能否找到足够的业务需求来消化?在C端市场,消费者是否愿意为AI服务买单?在B端市场,闭环的应用场景能否跑通?若答案是否定的,这场资本盛宴恐将演变为“重资产陷阱”的再现。

AI是否真的步入了“规模化商用”的新阶段?企业用户对于AI的接受度和支付意愿如何?云服务商的“智算基建”,究竟是铺就未来之路,还是埋下隐患之雷?

从2023年起,头部云服务商几乎集体开启了“智算军备竞赛”。亚马逊、微软、阿里、腾讯、百度、字节跳动等企业,在算力资源的扩张上不遗余力,积极构建万卡级GPU集群。在资本和媒体的渲染下,智算中心仿佛成了下一轮“国家级AI新基建”的象征。然而,这些投入远非简单地增加几台服务器所能比拟,而是一场千亿级规模的重资产豪赌。

据估算,构建一个万卡规模的H100训练平台,仅硬件采购就可能超过60亿元人民币。若将GPU采购、数据中心扩建、电力配套、网络互联、运维体系等成本纳入考量,单一智算中心的投资规模或高达80至120亿元。若在全国范围内布局,面向B端服务的平台化算力部署,三年内的投入轻松突破300至500亿元大关。

部分更为激进的企业,计划在未来3至5年内投入千亿级资金,专门用于智算平台的建设。这是一场关乎未来的豪赌,真金白银的投入能否换来预期的回报,至今仍是个未知数。

在C端市场,尽管大模型类产品如ChatGPT等已拥有亿级活跃用户,但商业化的道路却远非坦途。用户规模庞大并不等同于高收入,高频使用也不意味着愿意长期付费。订阅意愿有限、ARPU模型尚未稳定、用户使用场景多为轻度且可替代性高,这些都使得C端市场的AI服务虽具吸引力,但支付意愿却不足。平台因此陷入两难境地:关闭免费服务会影响用户转化,而高昂的算力成本又难以支撑。

相较于C端市场的“体验优先、轻付费”特征,云服务商对B端市场的商用前景寄予厚望。他们设想大模型将成为企业的“智能操作系统”,以API、SaaS、PaaS等形式嵌入各类行业系统,催生稳定的算力需求和持续的付费收入。然而,现实却远非如此。尽管企业客户在尝试使用大模型,但应用深度有限,决策依然保守。商用需求的增长幅度,远不及基础设施的扩张速度。

企业在大规模采用AI系统时,面临诸多挑战。输出内容的可信度、行为的可控性、责任边界的模糊性等问题,都使得企业在将AI部署到主业务系统时格外谨慎。高昂的推理成本、复杂的定价机制以及难以精确计算的ROI,都使得AI项目的预算有限、扩展困难。

当云服务商投入数百亿甚至千亿资金建设AI智算基础设施时,他们实际上是在押注一个前提:未来这套系统能被广泛使用,并持续产生商业收入。然而,若这个前提不成立,投入就可能从“战略资产”转变为“风险资产”。算力作为一种高度消耗型资源,不使用就会贬值。持续的电力和维护支出、账面折旧加速、投资回收期大幅拉长等问题,都将给企业财务带来巨大压力。

构建AI智算平台本身并无问题,问题在于当平台能力远超市场需求时,这些资本开支就可能成为失配资源。未来三年,将是决定这些投资是“高瞻远瞩”还是“高估预期”的关键窗口期。判断AI智算投资是否合理,需要从产业场景的刚性、付费路径的清晰稳定、客户体量的持续增长、模型能力的持续壁垒以及平台能否形成生态闭环等五个维度进行考量。

AI不是不能投,而是不能盲目地“先建起来再说”。基础设施的价值,永远建立在“能够被持续使用”的前提之上。未来的AI平台,其价值不仅在于“提供模型”,更在于能够稳定、低成本地提供持续演进的智能能力,嵌入行业流程中,解决实际问题。这需要模型能力、算力平台、服务体系与生态构建之间形成闭环。若这个闭环无法建立,再大的投资也可能只是重蹈覆辙,重演IT行业“重投入、轻转化”的老故事。