强化学习(RL)已成为大语言模型(LLM)后训练阶段的核心技术,从ChatGPT到DeepSeek的迭代中,其重要性愈发凸显。然而,随着模型参数规模的持续扩张,一个长期被忽视的问题逐渐浮出水面——重要性采样(Importance Sampling, IS)是否真的不可或缺?

近期,快手与清华大学联合研究团队发现,现有结果监督强化学习范式中存在深层次的权重错配现象。这种错配不仅导致模型产生“过度自信”倾向,还可能引发熵坍缩(模型输出多样性骤降)与训练早熟收敛(模型过早停止学习)。针对这一难题,研究团队提出了一种名为ASPO(Asymmetric Importance Sampling Policy Optimization)的算法,通过重构重要性采样机制,显著提升了模型性能与训练稳定性。

在传统强化学习中,重要性采样通过修正新旧策略间的分布差异,使模型能够“复用旧数据”而不偏离目标分布。这一机制在小规模场景中表现良好,但在大语言模型的结果监督强化学习中却逐渐失效。研究团队通过对比实验发现:在GRPO类算法中,保留重要性采样权重与完全移除该权重(统一设置为1.0)的模型,最终准确率几乎无差异;但移除重要性采样后,模型训练曲线更平滑,熵值下降速度放缓,重复输出率降低,且KL散度(衡量策略分布差异的指标)更稳定。

进一步分析揭示了重要性采样失效的根源。首先,结果监督强化学习中的优势值(Advantage Value)本身存在不准确性:不同token对最终答案的贡献差异显著,但传统方法却赋予它们相同的优势值;其次,正确回答中可能包含错误推理步骤,这些步骤的优势值甚至相互矛盾。更关键的是,正优势token的平均重要性采样权重显著高于负优势token,导致模型过度关注高概率正样本,加速了熵值的下降。

研究团队指出,重要性采样权重在LLM场景下出现了非对称性错误。对于负优势token,权重变化符合预期——旧策略概率固定时,当前概率越高,权重越高,从而抑制错误输出;但对于正优势token,权重分布却完全相反:当前概率越高的token权重越高,概率越低的token权重越低。这种偏差会形成自我强化循环,使模型不断强化已“高分”的token,而忽视需要改进的低概率token,最终导致模型陷入局部最优解,输出重复内容,甚至发生熵崩塌。

ASPO的核心创新在于“不对称翻转”正样本权重。具体而言,它将正优势token的重要性采样权重取倒数,使低概率token获得更强的更新信号,而高概率token的更新力度被适当削弱。为避免极端值导致的不稳定,ASPO引入了Dual-Clipping(软双重裁剪)机制,在保留正样本梯度有效流动的同时,限制极端比率的影响。ASPO仍保留原有的硬裁剪机制,对重要性采样比例异常的正负样本进行梯度裁剪。

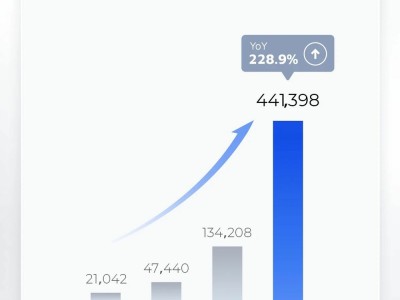

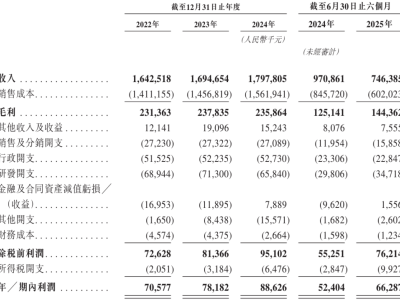

梯度分析显示,ASPO通过翻转重要性采样权重项,使梯度与token概率的倒数成正比。这意味着概率越低的token,获得的更新梯度越大,从而增强了低概率token的学习力度。实验结果表明,ASPO在数学推理(AIME24/25、AMC23、MATH-500、Minerva、Olympiad)和代码生成(LiveCodeBench v5/v6)等基准测试中表现优异:数学任务平均性能提升12.5%,代码生成任务平均性能提升17.0%;训练过程更平滑,无明显熵坍塌现象;在LiveCodeBench v5上,ASPO以31.5 avg@8 / 47.0 pass@8的成绩领先主流RL方法(如DAPO、DeepScaleR、Nemotron等)。

训练动力学分析进一步验证了ASPO的优势。其训练曲线显示,熵值下降更平缓,有效避免了传统算法中的“熵坍缩”问题,为模型提供了更稳定的探索空间。