在互联网的浩瀚信息海洋中,生成式人工智能(AI)的浪潮正以前所未有的速度席卷而来,使得辨别信息的真伪变得日益棘手。为了应对AI内容可能带来的网络污染问题,各方力量正积极寻求解决方案。近日,互联网工程任务组(IETF)发布了一项名为《AI内容披露标头》的草案,旨在通过在网页HTTP响应中添加可机读的标记,来标识内容的AI生成属性。

据IETF介绍,这一标记设计用于与HTTP结构化字段语法兼容,其目的在于向用户代理、网络爬虫及归档系统等提供关于AI在内容生成中参与度的元数据。这些系统可以根据自身需求,决定是否接受或处理AI生成的内容。此举直击AI领域的一大痛点:不同AI产品间的虚假内容循环引用,可能导致虚假信息被误认为是真实,进而扰乱整个互联网的内容生态。

AI之所以会“信口开河”,很大程度上源于其作为“概率预测机”的本质。AI大模型通过海量数据训练学习词语间的关联规律,但在处理不常见或复杂信息时,可能会因缺乏足够依据而“凭空创造”。当面对用户提问,AI若无法找到确切答案,便会倾向于生成一个概率上看起来最合理的答案,而非事实正确的答案。这种倾向性导致AI输出的内容往往看似合理,实则可能偏离事实。

AI幻觉现象虽难以完全避免,但已成为业界关注的焦点。更令人担忧的是,当多个AI产品开始相互引用这些虚假内容时,一个虚假的闭环便可能形成,使得虚构的信息逐渐被接受为真实。例如,近期一起关于明星王一博的谣言事件,就是由于AI在没有核实事实的情况下,基于语义关联性自动补全了内容,最终被另一款AI工具ChatGPT戳穿。

ChatGPT之所以能够在此次事件中发挥事实核查的作用,关键在于它与生成虚假道歉声明的AI使用了不同的训练数据。换句话说,ChatGPT因未被虚假内容污染,所以能够输出真实信息。然而,如果OpenAI的爬虫GPTBot抓取到了虚假的“道歉声明”,结果或将大相径庭。当前,为了提升模型智能度,AI厂商的爬虫几乎不加甄别地抓取数据,即使其中包含有害的虚假信息。

这种做法在学术界已引发“引用农场”现象,即通过相互引用将低质量论文塑造成高影响力论文。同样,当AI开始相互引用虚假内容时,用户将深受其害。IETF此次提出的《AI内容披露标头》草案,旨在从源头上阻止AI生成的虚假和垃圾内容回流至互联网,避免它们成为训练新AI模型的数据,从而陷入“垃圾进、垃圾出”的恶性循环。

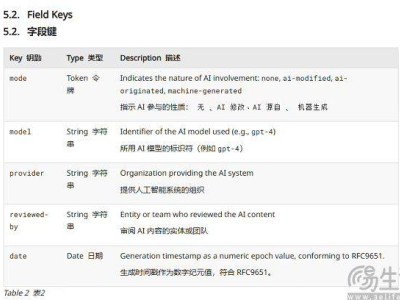

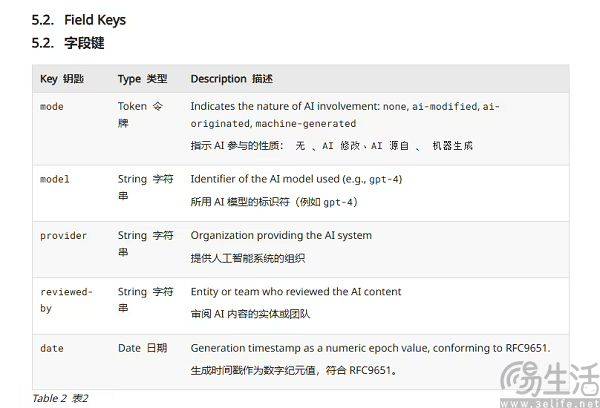

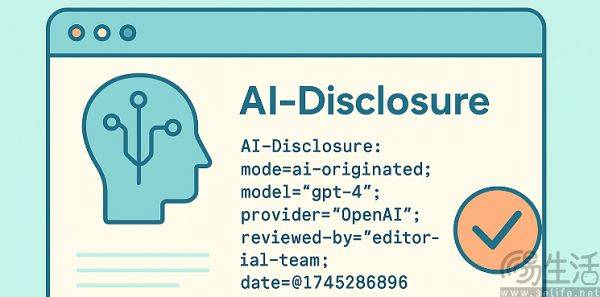

具体而言,IETF要求在HTTP文件中声明AI模型的名称、提供者、校验团队及时间戳等信息,以此防止AI厂商的爬虫错误地抓取AI生成的内容。实际上,AI厂商同样不希望抓取到AI内容,以免污染其训练数据。从某种程度上讲,《AI内容披露标头》草案与AI水印有相似之处,都是从内容生产和传播的起点入手,为“AI生成”内容打上独特的识别标签。

相较于技术实现难度较高的AI水印,要求网站主动披露内容是否由AI生成显然更加可行。关键在于,IETF作为负责互联网标准制定与推广的行业组织,其影响力不容小觑。HTTP和IPv6等互联网基础协议均出自IETF之手,可以说,当今的互联网是建立在IETF工作成果之上的。因此,IETF提出的这一草案,有望为净化网络内容生态、遏制AI虚假信息的传播发挥重要作用。