近期,一份深度聚焦于AI大模型跨域训练技术体系的白皮书引起了业界的广泛关注。这份名为《2025 AI大模型跨域训练池化调度技术体系白皮书》的报告,由紫金山实验室等机构联合编写,详细探讨了我国高端智能算力面临的“少、杂、散”问题,并提出了一套针对性的技术解决方案。

报告指出,在当前AI大模型的发展浪潮中,通用大模型的预训练需要万卡级的算力支持,而企业大模型的后训练则通常只需几十卡规模,更适合采用“算力网调度”的模式。为此,白皮书明确区分了“专用算力拉远”与“全局池化调度”两条技术路线。前者主要适配通用大模型的需求,后者则专注于解决企业大模型的跨域训练痛点,实现了“异属、异构、异地”资源的有效调度。

在技术架构方面,白皮书提出了一个包含业务层、管控层和资源层的三层核心架构。业务层负责接收训练任务并将其转化为标准描述;管控层则通过协同调度实现跨域资源的高效管理;资源层则负责整合各类异构计算资源。依托“广域确定性网络+智算资源并网+算网协同调度”的三位一体架构,该体系实现了“异属合训、异构混训、异地同训”的目标。

在关键技术层面,白皮书揭示了多项创新点。异构混训技术通过模型分层拆解和自适应配置,成功适配了不同型号的GPU。异地同训技术则借助计算通信重叠、算网协同调度和RDMA加速网关等技术手段,显著优化了跨域训练的效率。而异属合训技术则通过多队列协作、联合抢占和RDMA网络虚拟化等策略,打破了资源壁垒,实现了资源的灵活调度。

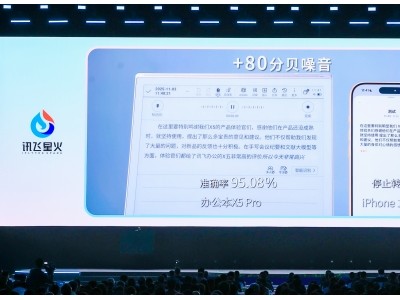

试验验证结果显示,在2000公里的广域网环境下,该体系的跨域训练效率达到了88.75%。在启用计算通信重叠技术后,效率更是提升至94.26%。同时,异构芯片混合训练的效率也高达95.47%。广域确定性网络还展现出了强大的抗干扰能力,有效抵御了干扰流的影响。

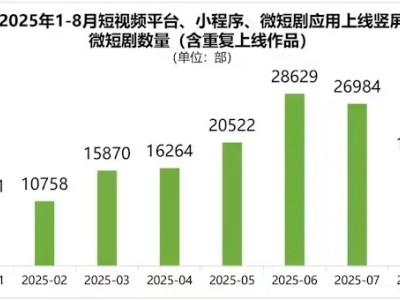

报告还展示了该体系在实际应用中的一些关键数据和图表,进一步证明了其有效性和可行性。例如,某企业在采用该体系进行跨域训练后,不仅显著提高了训练效率,还大大降低了算力成本。

随着AI技术的不断发展,算力需求将持续增长。该白皮书提出的AI大模型跨域训练池化调度技术体系,为我国高端智能算力的整合和优化提供了重要的参考和借鉴。未来,业界将继续探索和创新,推动算力资源的更高效利用和AI技术的更快发展。